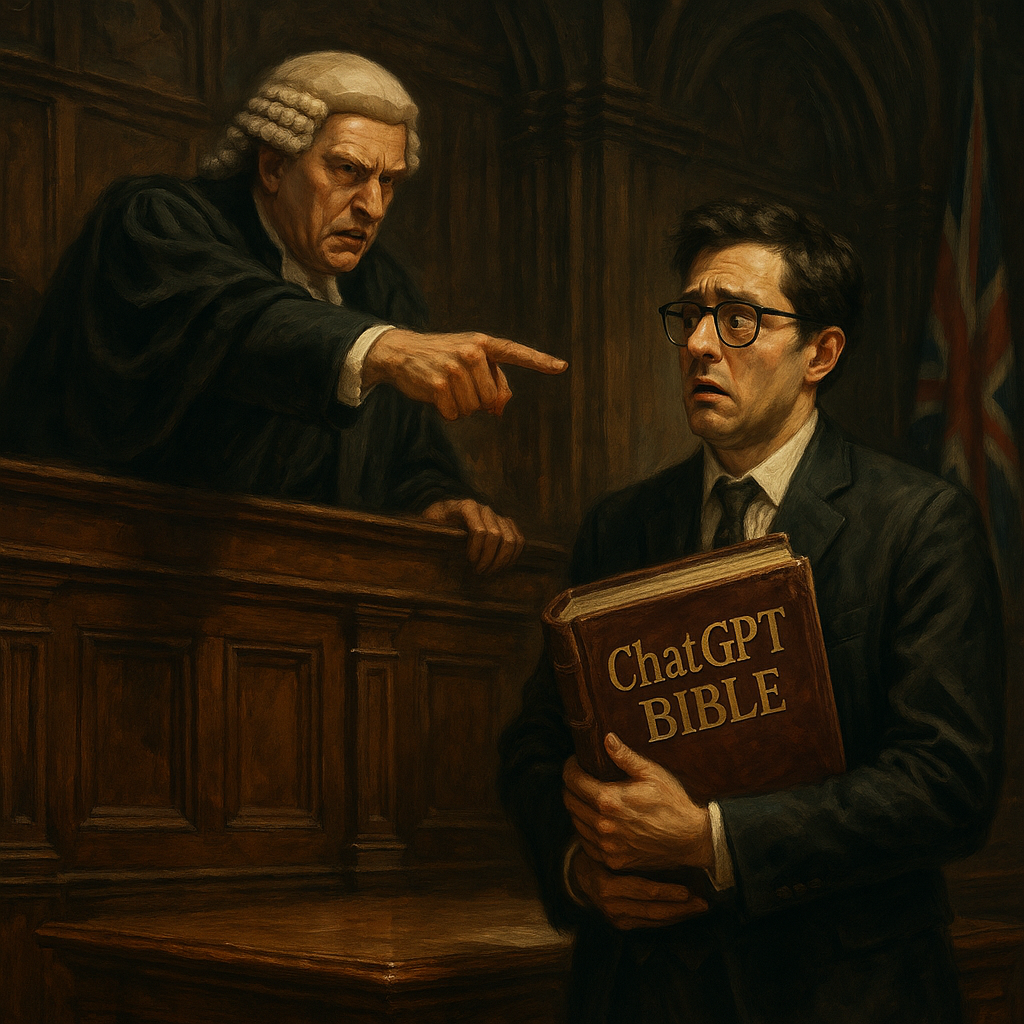

El uso imprudente de inteligencia artificial en los tribunales británicos acaba de recibir un duro revés. En una sentencia sin precedentes, el Tribunal Superior de Inglaterra y Gales advirtió que los abogados que presenten información falsa generada por IA podrían enfrentar cargos penales o la inhabilitación profesional.

El detonante fueron dos casos recientes en los que se detectaron fallos inexistentes y citas judiciales inventadas , presentadas como evidencia legal por abogados que utilizaron herramientas como ChatGPT. El fallo, emitido por Victoria Sharp , presidenta de la División King’s Bench, y el juez Jeremy Johnson , deja claro que la justicia no tolerará lo que denominaron “alucinaciones” generadas por inteligencia artificial.

Uno de los casos más alarmantes fue una demanda multimillonaria contra dos bancos. De las 45 citas legales presentadas por el demandante y su abogado, 18 eran completamente ficticias . En otros casos, las sentencias citadas existían, pero no incluían las referencias mencionadas ni respaldaban los argumentos legales.

El abogado defensor alegó haber confiado en la información proporcionada por su cliente —quien admitió haber usado herramientas de IA y buscadores legales— y no verificó los datos de forma independiente . Fue remitido al colegio de abogados por posible mala conducta.

El segundo caso, igual de desconcertante, involucró a un hombre desalojado que demandó a su ayuntamiento. Los abogados documentos presentados con cinco casos judiciales falsos para apoyar su reclamo. El tribunal descubrió el engaño tras notar el uso de ortografía estadounidense y un estilo narrativo sospechoso. La abogada negó haber usado IA, pero no pudo explicar el origen de las referencias inexistentes y admitió haber hecho lo mismo en otro caso.

La jueza Sharp fue contundente: “Las herramientas de IA como ChatGPT no son capaces de realizar investigaciones jurídicas confiables. Sus respuestas pueden parecer plausibles, pero son incorrectas y peligrosamente engañosas”.

La advertencia es clara: el mal uso de la inteligencia artificial no es solo una cuestión de ética profesional, sino un posible delito penal . Entre las sanciones posibles se encuentran el desacato al tribunal , la perversión de la justicia , e incluso el procesamiento criminal .

El fallo señala también que este no es un fenómeno exclusivo del Reino Unido. Casos similares han ocurrido en Estados Unidos, Australia, Canadá y Nueva Zelanda , donde abogados presentaron argumentos construidos sobre bases completamente ficticias, confiando ciegamente en herramientas de IA.

Aunque la justicia británica reconoce que la IA tiene usos legítimos —como en la organización de documentos o la transcripción de audiencias—, también advierte que su empleo irresponsable erosiona la confianza pública en el sistema judicial .

“La IA es una tecnología poderosa, pero no sustituye la diligencia, la verificación ni el juicio humano”, concluyó Sharp.

Este episodio marca un punto de inflexión. Si bien muchas profesiones —desde el periodismo hasta la medicina— están adaptando su trabajo a los avances de la IA, el ámbito jurídico enfrenta un dilema particularmente delicado: el riesgo de contaminar el proceso judicial con verdades fabricadas .

Con este fallo, el Tribunal Superior británico no solo advierte a los profesionales del derecho: lanza un mensaje global sobre los límites de la automatización en la búsqueda de justicia .